Paradox

Das Wort Knicklichtpower setzt sich aus 2 Worten zusammen.

Raver spielen im Dunkeln gerne mit Knicklichtern. Das sind Leuchtstäbe aus biegsamer Plastik, die in verschiedenen Farben von allein leuchten, wenn man sie knickt.

Übersetzung :

Kraft {f}

Leistung {f}phys.

Macht {f}

Strom {m}electr.

Energie {f}

Gewalt {f} [Macht, Herrschaft; elementare Kraft]

Antriebskraft {f}tech.

Vollmacht {f}law

Mächtigkeit {f}

Power {f} [ugs.]

elektrische Energie {f}electr.

Potenz {f} [kreativ, geistig, ökonomisch etc.]

Stärke {f} [Schlag, Explosion etc.]

Schubkraft {f}aviat.

Vermögen {n} [Fähigkeit]

Befugnis {f}

Leistungsvermögen {n}

Teststärke {f}math.stat.

Wirkmacht {f}

Knicklichtpower hat somit viele Bedeutungen.

https://www.youtube.com/watch?v=2bpc5rECBwU&feature=youtu.be

Lieber Jöööörg, ne halbe Stunde meines Lebens widtme ich dir.

… Und ausserdem wollte ich dir noch vorführen das ich dich markieren kann, obwohl wir ja jetzt gar keine Freunde mehr sind 😀 😀

Für dich hab ich jetzt meinen Gedanken mal freien Lauf gelassen…zukünftig wird die Prozedur aber dann etwas flotter voran schreiten denn umso schneller haben wa den ganzen Mist ja abgearbeitet, ne :*

I believe in Pappenheimer & die üblichen Verdächtigen!!! 😉

Aus der Kategorie «Studien, die kein Schwein braucht» kommt hier nun ein Beitrag über den Rückgang von Eheschliessungen wegen übermässigem Pornokonsum. Machen Pornos einsam?

Forscher sind arme Schweine. Sie unterliegen einem Publikationsdruck, um ihre wissenschaftliche Reputation zu steigern und publizieren dafür immer öfters Thesen, bei denen sich einem die Nackenhaare sträuben. Jüngstes Beispiel:

Die Männer heiraten weniger oft, weil sie zu viele Pornos konsumieren.

Ich habe mich mal überwunden und die Studie analysiert. Auslöser war die weltbewegende Erkenntnis, dass verheiratete Männer weniger oft Porno-Seiten im Internet aufrufen als ledige Männer. Daraus haben die Forscher dann den völlig plausiblen Schluss gezogen, dass übermässiger Pornokonsum verhindert, dass Männer heiraten.

Hier meine Gegenthese:

Üblicherweise schauen Männer Pornos, um sich aufzugeilen und sich einen runterzuholen. Ich könnte mir vorstellen, dass die Partnerin keine grosse Lust hat, diesem Treiben zuzusehen, ausser man geilt sich gemeinsam an Pornos auf, um anschliessend Sex zu haben. Pornos schauen ist somit eine Tätigkeit, die Männer eher im Verborgenen tun. Dies ist für ledige Männer, die nicht in einer festen Beziehung zusammenleben, einfacher als für Verheiratete. Könnten verheiratete Männer genauso einfach Pornos konsumieren wie die Ledigen, dann wären die Unterschiede beim Pornokonsum wohl deutlich geringer.

Dies ist die These eines Praktikers, da werde ich bei Theoretikern wohl kein Gehör finden.

Die Forscher sind sich nicht zu schade, um zu behaupten, dass Pornos die Ehe überflüssig machen, weil Männer ja nur heiraten, um sich sexuell austoben zu können. Der Pornokonsum ist da deutlich einfacher, weil man die Frau nicht noch erst erobern muss.

Hier meine Gegenthese:

Wenn ein Mann Sex haben möchte, kann er problemlos auf die Liebesdienste von Sexarbeiterinnen (umgangssprachlich Nutten genannt) zurückgreifen. Dies kommt erst noch günstiger als eine Scheidung, deren Eintrittswahrscheinlichkeit bei ca. 50% liegt. Vermutlich haben Männer deshalb keinen Bock mehr auf die Ehe, weil das finanzielle Risiko zu hoch ist (speziell, wenn noch Kinder zu versorgen sind).

Wenn ein Mann heiratet, tut er dies, weil er mit seiner Lebensabschnittspartnerin einen Lebensabschnitt verbringen oder eine Familie gründen möchte, und nicht nur aus sexuellen Gründen!

Bei solchen Studien interessiert mich deshalb eigentlich nur eine Frage:

Wurden dafür Steuergelder verschwendet?

–

Aaron T. Schwarz

Die Entstehung der elektroakustischen und elektronischen Musik ist eng mit den Bereichen der Mathematik, Physik, Akustik, Mechanik und den wissenschaftlichen Entdeckungen verbunden.

Auch die gesellschaftlichen Veränderungen, die durch die Industrialisierung stattfanden, sind von grosser Bedeutung.

In den 1850er Jahren wurden wichtige Meilensteine in der Mechanik und Wissenschaften gesetzt, die für die Entwicklung der elektronischen Musik ausschlaggebend waren. Weitere Fortschritte wurden durch die Verbreitung von elektrischen Anlagen in den Grossstädten bewirkt.

André-Marie Ampère war ein französischer Physiker und Mathematiker. Die SI-Einheit der Messung des elektrischen Stroms in Ampere, wurde nach ihm benannt. Alessandro Giuseppe Antonio Anastasio Volta war an italianischer Physiker. Die SI-Einheit der Messung der elektrischen Spannung in Volt, wurde nach ihm benannt. Georg Simon Ohm war ein deutscher Physiker und Mathematiker. Die SI-Einheit der Messung des elektrischen Widerstands in Ohm, wurde nach ihm benannt. James Watt war ein schottischer Erfinder und Maschinenbauer. Die SI-Einheit der Messung der elektrischen Leistung in Watt, wurde nach ihm benannt.

Ab dem 20. Jahrhundert, mit dem Aufkommen der technischen Fortschritte im Bereich der klassischen Physik und der Quantenphysik sowie der Entwicklung der Psychologie und der Psychoanalyse ereigneten sich bedeutende Wandlungen in der Weltanschauung. Dieser Paradigmawechsel inspirierte Künstler, Dichter, Maler, die neue Wege des Ausdrucks entfesselten wie Surrealismus, Dadaismus, Kubismus, Futurismus. Die Experimente in der elektronischen Musik wurden in den Status der Kunst erhoben.

Seit den 1950er Jahren entwickelt sich parallel zur elektronischen Musik der Computer, und die ersten Versuche von Musik-Programmiersprachen wurden gestartet.

Seit jener Zeit haben sich die Rechner in ihrer Leistungsfähigkeit enorm entwickelt und die Geräte wurden laufend kleiner.

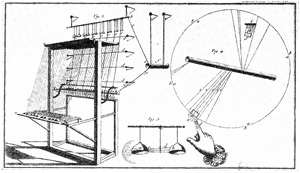

Bereits aus dem 18. Jahrhundert sind Experimente mit elektrischen Kräften und erste Maschinen, die zur Erzeugung von Elektrizität durch Reibung konstruiert wurden, bekannt.

Bereits aus dem 18. Jahrhundert sind Experimente mit elektrischen Kräften und erste Maschinen, die zur Erzeugung von Elektrizität durch Reibung konstruiert wurden, bekannt.

Der Jesuitenpater Jean Baptiste Delabordes berichtet im Jahre 1759 über ein „clavecin électrique“. Es handelt sich um ein elektrisches Musikinstrument mit Tastatur, das durch die Ausnutzung der anziehenden und abstossenden Kraft der Elektrizität Pendel in Bewegung setzte, die wiederum Glocken zum Klingen brachten.

Im 19 Jhr. erreichten die elektrophysikalischen Entdeckungen und Fortschritte zentrale Bereiche des kulturellen Lebens: Mit der Strassenbeleuchtung, dem elektrischen Schienenverkehr, der Telegraphie, aber auch mit den ersten Telephonverbindungen.

Diese Entwicklung wurde möglich, durch die Entdeckung des Kondensators von Alessandro Volta, die hundert Jahre davor, nämlich im Jahr 1800 stattgefunden hatte.

Dies führte die nachfolgenden Forscher dazu, Beziehungen zwischen Elektrizität und Magnetismus zu studieren und weiter zu entwickeln.

Dies führte die nachfolgenden Forscher dazu, Beziehungen zwischen Elektrizität und Magnetismus zu studieren und weiter zu entwickeln.

Eine wichtige Erfindung im musikalischen Bereich war der Selbstunterbrecher, der im Jahre 1837 von Johann Philipp Wagner entdeckt wurde.

Es handelt sich um ein rudimentäres elektrisches Musikinstrument, das auf dem Prinzip basiert, Bewegungsvorgänge und Schwingungen mechanischer Klangkörper elektromagnetisch auszulösen, sowie mechanische Schwingungen z.B. von Saiten aufrecht zu erhalten.

Etwas später,um 1860 erweiterte Hermann von Helmholtzden Selbstunterbrecher zu eine Stimmgabelunterbrecher, der die akustischen Schwingungen der beiden Federn aufrechterhalten konnte

Im Jahre 1884 ging Robert Kirk Boyle aus Liverpool einen Schritt weiter und verwendete statt Stimmgabeln Saiten als Selbstunterbrecher. Im gleichen Jahr arbeitete Ernst Lorenz aus Frankfurt an einem ähnlichem Instrument, wobei er über eine Tastatur eine Reihe von Selbstunterbrechern betätigte, die aus abgestimmten Federn in verschiedenen Tonhöhen bestand.

Indem er die Federn in sauerstoffreien Boxen isolierte, vermied er die rein akustische Abstrahlung der Schwingungen. Er war einer der Ersten, der auf das Problem der akustischen Abstrahlung in Zusammenhang mit elektrischen Schwingungen hinwies.

Auch der Bereich der Telegraphie und der Telephonie und deren Innovationen waren wichtig für die musikalischen Versuche und Entwicklungen. 1821 enwickelte Charles Wheatstone das Telepehon, das ursprünglich als mechanisches Musikinstrument gedacht war. 1837 war das Jahr der Entwicklung der elektromagnetischen Telephonie.

Sie basiert auf dem Effekt, der galvanische Musik genannt wurde, bei welchem Elektromagneten unter gewissen Umständen tönen können.

Sie basiert auf dem Effekt, der galvanische Musik genannt wurde, bei welchem Elektromagneten unter gewissen Umständen tönen können.

Smith und May entdeckten im Jahre 1873, dass durch den Einfluss der Lichtstrahlen der elektrische Widerstand von Selen verändert werden konnte. Dies bot die Möglichkeit, Lichtstrahlen in elektrische Energie umzuwandeln.

Das erste elektronische Musikinstrument ist der Singende Lichtbogen. Dieses Instrument basiert auf der Feststellung, dass ein elektrischer Lichtbogen, der zu einem Schwingungskreis parallel gelegt wird, einen pfeiffenden, fast musikalischen Ton produziert.

Der Kondensator lädt sich mit dem Gleichstrom auf und entlädt sich „rhyhtmisch“ über den Lichtbogen, der hörbare Schwingungen in der Luft anregt.

Ein weiterer Schub zeigt sich in den 1990er Jahren und Entwicklungen setzen sich mit enormen Tempo fort. Eine der Entwicklungen ist das Internet,.

Elektromechanische und Elektronische Klangerzeugung

Bevor wir uns weiter in die Entwicklung der elektronischen Musik vertiefen, möchte ich an dieser Stelle den Unterschied zwischen elektromechanischer und elektronischer Klangerzeugung klären. Dies ist besonders wichtig, da die Maschinen, die in den folgenden Kapiteln erwähnt werden, diese zwei Grundprinzipien benutzen.

Ein bewegender Mechanismus (wie z.B. drehendes Rad) produziert alleine keinen Klang, aber eine regelmässige Schwingung. In der Elektronik hat man sich diese Beoabchtung zu Nutze gemacht und innerhalb eines Stromkreises angewendet. Eine regelmässige Schwingung innerhalb eines Stromkreises kann in hörbare Schwingungen umgewandelt werden. Jedes elektromechanische Filter kann durch Rückkopplung zu Dauerschwingungen angeregt werden. Ein anderer Weg zur Erzeugung von elektrischen Schwingungen ist, die Schwingbewegung durch eine Drehbewegung zu ersetzen. Die Zähne einer Profilscheibe bilden abwechseln Nord- und Südpole, wenn die Scheibe mit konstanter Geschwindigkeit vor einem Abnahmemagneten rotiert. Die Schwingungsfrequenz hängt von der Zahl der Pole und der Umdrehungszahl ab. Die Klangfarbe ist anderseits abhängig von der Kontur der Scheibenränder. Die Scheiben mit zackigem Rand erzeugen mehr Oberwellen als diejenigen mit glattem Rand.

Ein bewegender Mechanismus (wie z.B. drehendes Rad) produziert alleine keinen Klang, aber eine regelmässige Schwingung. In der Elektronik hat man sich diese Beoabchtung zu Nutze gemacht und innerhalb eines Stromkreises angewendet. Eine regelmässige Schwingung innerhalb eines Stromkreises kann in hörbare Schwingungen umgewandelt werden. Jedes elektromechanische Filter kann durch Rückkopplung zu Dauerschwingungen angeregt werden. Ein anderer Weg zur Erzeugung von elektrischen Schwingungen ist, die Schwingbewegung durch eine Drehbewegung zu ersetzen. Die Zähne einer Profilscheibe bilden abwechseln Nord- und Südpole, wenn die Scheibe mit konstanter Geschwindigkeit vor einem Abnahmemagneten rotiert. Die Schwingungsfrequenz hängt von der Zahl der Pole und der Umdrehungszahl ab. Die Klangfarbe ist anderseits abhängig von der Kontur der Scheibenränder. Die Scheiben mit zackigem Rand erzeugen mehr Oberwellen als diejenigen mit glattem Rand.

Die elektronische Klangerzeugung ist etwas komplizierter. Mit Hilfe von Elektronenröhren und Gasentladungsröhren kann man auch niederfrequente Schwingungen erzeugen und hörbar machen. Als erstes werden die Schwingungen, die aus stromerzeugende Generatoren entstehen, konstant gehalten. Die Elektronenröhren kann man auf verschieden Arten zur Schwingerzeugung bringen. Mit der Nutzung des Rückkopplungsprinzips kann man durch Hinzufügung eines Schwingungskreises einen Generator für Sinus- und Kippschwingungen aufbauen. Die Tonhöhe kann durch die Veränderung der Kapazität geregelt werden. Es ist aber auch möglich ohne Schwingkreis Schwingungen zu erzeugen.

Die Glimmröhre ist mit Gas gefüllt und ist mit zwei oder mehreren Elektroden ausgerüstet.

Zwischen den Elektroden finden Entladungen statt, die direkt hörbare Schwingungen erzeugen. Die Frequenz kann man mit einem Ohmscher Widerstand absenken.

Obertonreiche Impulse erhält man, wenn man die Spannung an einem Vorwiderstand abnimmt.

Hiermit stehen zwei Methoden zur Verfügung, mit dem Klang arbeiten zu können.

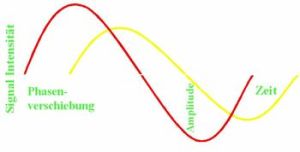

Der Klang hat drei Bestimmungsgrössen, die verändert werden können. Folgende Tabelle veranschaulicht diese drei Parameter, indem sie die Rezeption des menschlichen Gehörs und die Grössen der Akustik gegenüberstellt:

Das menschliche Ohr

Lautstärke

Tonhöhe

Klangfarbe

Akustik

Amplitude der Welle

Frequenz (Hz)

Spektrale Zusammensetzung

Alle diese drei Parameter sind veränderbar, somit sind sie modulierbar. Die Amplitude kann man durch additive oder subtraktives Klangssyntheseverfahren verändern.

Je nachdem welches Verfahren angewendet wird, kann man einen Ton mit Obertönen bereichern oder verarmen.

Die Frequenz ist umgekehrt proportional zu den Schwingungen, die pro Sekunde entstehen. Sie kann meistens mit einem Generator verändert werden. Die Klangfarbe kann durch Filter verändert werden, die beliebige Teiltongruppen hervorheben oder unterdrücken können. Diese Selektionsverfahren beruhen auf Resonanzerscheinungen (Formanten).

Die Anfänge: Ab 1900

Beginnen wir mit einer kurzen Definition der elektronischen Musk. Im weiteren Sinne bezeichnet dieser Begriff jegliche Art von Musik, die mit elektronischen Geräten erzeugt wird. Im strengeren Sinne bezeichnet sie die Musik, die mit Hilfe von Instrumenten und Komponenten (wie. z.B Peripheriegeräte des Computers) aus Klangsynthese erzeugt wird.

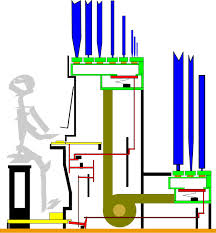

Das erste elektromagnetische Musikinstrument ist eine Erfindung von Thaddeus Cahill von 1897 und ist unter den Namen des Dynamophon oder Tellharmonium bekannt. Die Erfindung Cahill’s zog das Interesse von Ferruccio Busoni auf sich. Das bearbeitete Modell wurde 1906 in Holyoke, Massachusetts, dem Publikum  präsentiert. Weil es im gleichen Jahr in der Telharmonic Hall in New York präsentiert wurde, wird das Dynamophon auch Tellharmonium genannt.

präsentiert. Weil es im gleichen Jahr in der Telharmonic Hall in New York präsentiert wurde, wird das Dynamophon auch Tellharmonium genannt.

Bereits 86 Jahre vor dieser Erfindung, wurde Klang mathematisch definiert. Die bekannteste Methode zu mathematischen Beschreibung des Klanges wurde 1811 vom französischen Mathematiker Jean Fourier entwickelt.

Mit seiner Methode, der Fourieranalyse, lassen sich periodische Schwingungen in harmonische, sinusförmige Teilschwingungen zerlegen. Die additive Klangsynthese von Fourier ermöglicht beliebige Klänge durch additive Übereinanderlagerung  verschiedener Sinusschwingungen zu erzeugen. Diese Methode wurde für die analogen Studios Mitter der 1950er Jahren entscheidend, und später wurde sie in den Computern angewendet.

verschiedener Sinusschwingungen zu erzeugen. Diese Methode wurde für die analogen Studios Mitter der 1950er Jahren entscheidend, und später wurde sie in den Computern angewendet.

Nach dieser Erfindung wurden viele neue elektronischen Instrumente entwickelt und eingeführt. Im Folgenden werde ich die wichtigsten etwas näher beschreiben:

Das Theremin ist bis heute das einzige Instrument , das man  berührungsfrei bedient. Das Instrument wurde vom Physiker und Cellist aus St. Petersburg, Leon Theremin erfunden. Das Instrument ist einstimmig und lässt sich mit beiden Händen steuern. Es handelt sich um ein grosses Stehpult mit zwei Antennen: links eine kreisförmige gebogene, rechts eine gerade Antenne. Die eine Hand steuert mit Handbewegung die Tonhöhe, die andere die Lautstärke. Dieses funktioniert mit zwei Hochfrequenzoszillatoren: Der Oszillator arbeitet mit einer konstanten Frequenz von 170 kHz, der zweite lässt sich im Bereich von 168-170 kHz varieren. Die Steuerung funtioniert mit der Antenne, die ein elektrisches Feld erzeugt. Die menschliche Hand bewirkt eine Veränderung im elektrischen Feld, und beinflusst die Steuerung des zweiten Oszillators. Die Differenzfrequenz erzeugt einen hörbaren Ton. Clara Rockmore war die erste Virtuosin des Theremins.

berührungsfrei bedient. Das Instrument wurde vom Physiker und Cellist aus St. Petersburg, Leon Theremin erfunden. Das Instrument ist einstimmig und lässt sich mit beiden Händen steuern. Es handelt sich um ein grosses Stehpult mit zwei Antennen: links eine kreisförmige gebogene, rechts eine gerade Antenne. Die eine Hand steuert mit Handbewegung die Tonhöhe, die andere die Lautstärke. Dieses funktioniert mit zwei Hochfrequenzoszillatoren: Der Oszillator arbeitet mit einer konstanten Frequenz von 170 kHz, der zweite lässt sich im Bereich von 168-170 kHz varieren. Die Steuerung funtioniert mit der Antenne, die ein elektrisches Feld erzeugt. Die menschliche Hand bewirkt eine Veränderung im elektrischen Feld, und beinflusst die Steuerung des zweiten Oszillators. Die Differenzfrequenz erzeugt einen hörbaren Ton. Clara Rockmore war die erste Virtuosin des Theremins.

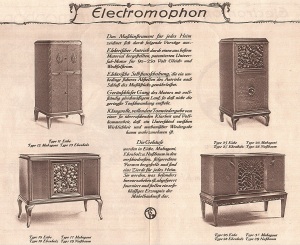

Das Sphärophon wurde von Jörg Mager um 1926 erfunden. Es  wurde auch Elektrophon oder Elektromophon genannt. Es besteht aus zwei hochfrequenten elektronischen Schwingkreisen. Mit einem Kurbelapparat kann die Kapazität des Kondensators verändert werden, der als Steuerungsmechanismus für die Tonhöhe des erzeugten Tones dient. Das Sphärophon funktioniert nach dem Prinzip des Schwebungssummers.

wurde auch Elektrophon oder Elektromophon genannt. Es besteht aus zwei hochfrequenten elektronischen Schwingkreisen. Mit einem Kurbelapparat kann die Kapazität des Kondensators verändert werden, der als Steuerungsmechanismus für die Tonhöhe des erzeugten Tones dient. Das Sphärophon funktioniert nach dem Prinzip des Schwebungssummers.

Ein Schwebungssummer ist eine elektronische Schaltung mit der eine Sinusschwingung mit einer niedrigen Frequenz aus der Überlagerung zweier dicht beieinander liegender Sinusschwingungen hörbarer Frequenzen ereugt wird. Mit Hilfe einer Kurbel konnte Mager auch sehr kleine Tonintervalle einstellen sowie gleitende Töne spielen. Das Instrument wurde von einem Spielttisch aus betätigt, auf dem die Töne als Masseinteilung eingezeichnet waren. Die zwei Kurbeln wurden abwechselnd mit der rechten und linken Hand bedient. Zur Schliessung des Stromkreises befand sich auf den Griffen einen Druckknopf. Während der Ton erklang, stellte die zweite Hand die andere Kurbel auf den gleichen Ton ein, so dass die erste Kurbel frei wurde für eine neue Toneinstellung.

Ein Schwebungssummer ist eine elektronische Schaltung mit der eine Sinusschwingung mit einer niedrigen Frequenz aus der Überlagerung zweier dicht beieinander liegender Sinusschwingungen hörbarer Frequenzen ereugt wird. Mit Hilfe einer Kurbel konnte Mager auch sehr kleine Tonintervalle einstellen sowie gleitende Töne spielen. Das Instrument wurde von einem Spielttisch aus betätigt, auf dem die Töne als Masseinteilung eingezeichnet waren. Die zwei Kurbeln wurden abwechselnd mit der rechten und linken Hand bedient. Zur Schliessung des Stromkreises befand sich auf den Griffen einen Druckknopf. Während der Ton erklang, stellte die zweite Hand die andere Kurbel auf den gleichen Ton ein, so dass die erste Kurbel frei wurde für eine neue Toneinstellung.

Die Ondes Martenot sind ein einstimmiges, elektronisches Musikinstrument. Es wurde von dem französischen Musikpädagogen und Radioamateur Maurice Martenot erfunden. Er liess sich von der Erfingung von Theremin inspirieren, nachdem sie sich im Jahre 1923 getroffen hatten.

Die Ondes Martenot sind ein einstimmiges, elektronisches Musikinstrument. Es wurde von dem französischen Musikpädagogen und Radioamateur Maurice Martenot erfunden. Er liess sich von der Erfingung von Theremin inspirieren, nachdem sie sich im Jahre 1923 getroffen hatten.

Auch die Ondes Martenot basieren auf dem Prinzip des Schwebungssummers und der Klang kann mit elektronsichen Filtern verändert werden. Die rechte Hand bedient ein Manual. Für ein Glissanso kann der Spieler einen Ring, der parallel zur Tastatur, die zur visuellen Orientierung dient und geführt wird, verschieben. Mit der linken Hand kann der Spieler die Lautstärke regeln und die Klangfarbe verändern.

Das Givelet oder „Orgue des Ondes“ wurde 1929 von Armand Givelet erfunden.

Das Instrument basiert auf der Technologie des Theremins und der Ondes-Martenot, aber da jede Taste einen Oszillator besass, war das Instrument polyphon. Die Orgel besass 700 Vakuum-Oszillatoren, die es ermöglichten, eine Tastatur von 70 Tönen zu entwickeln.

Das Givelet wurde bald von der Hammond-Orgel ersetzt, die wegen ihrem einzigartigen Klangcharakter zum Erfolg wurde. Dieses Instrument war viel erfolgreicher, das sie polyphon war und wurde als Substitut der Orgel konstruiert, aber auch an Stelle des Klaviers in der Populärmusik verwendet.

Die Hammond-Orgel ist eine Erfindung von Laurens Hammond.  Diese Orgel verbreitete sich sehr schnell im Jazz und wurde als billiger Ersatz der Orgel in den Kirchen für die Gospel-Musik verwendet.

Diese Orgel verbreitete sich sehr schnell im Jazz und wurde als billiger Ersatz der Orgel in den Kirchen für die Gospel-Musik verwendet.

Weiter wurde sie in der Rockmusik, R&B, Soul, Funk und Fusion eingesetzt. 1934 erhielt Hammond das Patent und kurz darauf wurde er vom Erfinder des Laufbandes, Henry Ford, beauftragt, sechs Orgeln zu bauen.

Die Töne werden durch einen Zahnradoszillator erzeugt. Metallene Tonräder mit einem sinusförmigen Rand rotieren vor einem elektromagnetischen Tonabnehemer. Durch die Wellenform entfernt und nähert sich der Rand des Rades periodisch dem Eisenkern.

Dies bewirkt eine Veränderung des Magnetfeldes, wodurch die Spule eine Wechselspannung induziert und einen Wechselstrom treibt.

Der Zahnradoszillator enthält 91 Tonräder unterschiedlicher Zahnanzahl, die auf einer gemeinsamen Achse stecken, die von einem Synchronmotor über ein Übersetzungsgetriebe angetrieben werden.

Das Instrument hat den Nacht n Der Vocoder ist 1939 aus der militärischen Forschung als Instrument zur Stimmverschlüsselung erfunden worden.

Der Vocoder basiert auf dem Prinzip der Bijektivität. Er verknüpft zwei Eingangssignale miteinander vobei das Spektrum des Signals A auf das andere Signal B formend wirkt. Das Signal A wird analysiert. Sein Spektrum beeinflusst dasjenige des Signals.

Der Vocoder basiert auf dem Prinzip der Bijektivität. Er verknüpft zwei Eingangssignale miteinander vobei das Spektrum des Signals A auf das andere Signal B formend wirkt. Das Signal A wird analysiert. Sein Spektrum beeinflusst dasjenige des Signals.

Das Trautonium wurde von Friedrich Trautwein erbaut. Dieses elektronische Instrument ist ein Vorläufer der heutigen Synthesizer.

Es beruht auf der subhamonischen Tonleiter. Die Kombination von vier subharmonischen Töne bilden eine Mixtur. Die Mixturen bewirken einen Mehrklang.

Die technologischen Erneuerungen erreichten verschiedene europäische Länder, wie Deutschland, Frankreich und auch Italien. Die italienischen Futuristen wie Filippo Martinetti und Balilla Pratella begrüssten diese neuen Technologien und sahen darin, neue Ausdrucksmöglichkeiten zu entdecken, um die traditionelle musikalischen Prinzipien bei Seite zu lassen.

Sie alle meinten, dass man neue Klangquellen erforschen und fördern sollte, um unendlich viele neue Möglichkeiten zu entdecken.

Die erste Aufführung mit dem „Intonarumori“ fand im Juni 1913 im Teatro Storchi in Mailand statt. Die Futuristen haben mit diesem neuen Weg zwar keine Revolution in der Musik bewirken können, aber sie leisteten eine Vorarbeit, welche die Akustik und die neue Musik zusammenführte.

Die erste Aufführung mit dem „Intonarumori“ fand im Juni 1913 im Teatro Storchi in Mailand statt. Die Futuristen haben mit diesem neuen Weg zwar keine Revolution in der Musik bewirken können, aber sie leisteten eine Vorarbeit, welche die Akustik und die neue Musik zusammenführte.1942 gründet Pierre Schaeffer das „Studio d’essay“, ein akustisches Versuchsstudio. Die Bezeichnung „Musique concrète“ wurde von ihm, der Toningenieur und Komponist war, 1948 in Paris eingeführt. Die Werke der Anfänge der Musique conrète sind durch das Verfahren, vokale und instrumentale Klänge zu transformieren und als Material für neue musikalische Strukturen benützen, gekennzeichnet. Nach der Schallplatten- und Tonbandaufnahme von konkreten Klängen und Geräuschen (daher die Bezeichnung von konkreter Musik), werden Klangfragmente ausgewählt, die mittels elektroakustischer Apparaturen bearbeitet werden.

1953 stiess die Uraufführung von Schaeffer und Pierre Henry’s Spectacle lyrique „Orphoe“ bei den Donauschinger Musiktagen auf heftigem Widerstand.

Die Musique conrète fand jedoch nicht nur Widerspruch, sondern auch Anklang in der ganzen Welt. Zu den wichtigsten Exponenten gehören unter anderem auch François Bayle, Pierre Boulez und Jean Barraqué. Die Musique concrète wurde zudem bald im Rundfunk, Theater, Ballet, Film und Fernsehen ausgestrahlt. Junge französische sowie ausländische Komponisten wie Mache, Ferrari und Bayle wurden eingeladen, in Paris zu arbeiten.

In der gleichen Zeit arbeiteten Usachewsky mit seiner „Music for Tape“ und John Cage mit seinen Experimente auf ähnlicher Weise. Die amerikanische Variante der Musique Concrète ist die Tape Music. Weitere Komponisten wie Honegger, Milhaud, Messiaen, Sauguet, Scherchen unternahmen eigene Versuche.

Elektroakustische Musik vereint verschiedene Gebiete wie Musique Concrète, Elektronische Musik, Tape Musik, Live Electronic-Musik sowie Teile der Computermusik. Der Begriff Elektroakustische Musik stammt ursprünglich von Iannis Xenakis, der in den 1950er Jahren seine Tonbandkompositionen so nannte.

Elektroakustische Musik ist auf Lautsprechewiedergabe angewiesen, deshalb wird sie auch als Lautsprechermusik bezeichnet, da die Instrumente tatsächlich die Lautsprecher sind. Die elektroakustische Musik braucht keinen Interpreten, da sie direkt auf einen Tonträger fixiert wird. Deshalb wird sie auch als unsichtbare oder authentische Musik bezeichnet. Somit hat sie auch die Aufführungspraxis und die Klangästhetik so weit verändert, da sie überall gleich ist.

Anfang der 1950er Jahre wurden in den Bell Telephone Laboriatorires von New Jersey die ersten Versuche gestartet, ein Programm zu entwickeln, das Klang für mit einem Computer synthetisieren kann.

Lejaren Hiller und Leonard M. Isaacson entwickelten in den Jahren 1956-57 mit dem für die chemische Forschung entwickelten Rechner ILLIAC I an der Universität von Illinois, Urbana, die ersten Computeralgorithmen und Partitursynthesen. Aus dieser Arbeit entstand die ILLIAC Suite, auch „String Quartet No. 4“ genannt.

Mit dieser Suite erforschten sie, wie sie für Genre und Stil ein spezifisches Regelsystem entwickeln konnten und in Computeralgorhythmen darstellen konnten. Beim ersten Experiment entstand „Monody, two-part, and four-part wirting“. Es wurden 16 verschiedene Kontrapunktregeln programmiert mit den Optionen erlaubt-verboten-norm, dazu kamen Regeln für einfache Mehrstimmigkeit. Das Ergebnis waren einfache cantus-Firmus-Melodien.

Beim zweiten Experiment „Four-part first-species counterpoint“ wurden die Regeln des ersten Experiments erweitert, so dass unterschiedliche musikalische Stile entstanden. Beim dritten Versuch wurden serielle Strukturen und Reihentechniken programmiert, das vierte Experiment bestand aus den sogenannten „Markov-Ketten“, komplizierte mathematische Prozesse, die durch Abläufe, bei denen der Zufall wirkt, bestimmt werden.

Die Musikstücke lassen sich somit als eine Folge von bedingten Wahrscheinlickeiten darstellen.

Der Bonner Akustiker und Phonetiker Werner Meyer-Eppler erarbeitete um 1950 Klangmodelle, bei der elektrisch erzeugte und modulierte Klänge auf Tonband gespeichert werden konnten. Er wollte so eine authentische Musik kreieren, die unabhängig von einem Interpreten war. Er bediente sich eines Melochords, das er mit externen Klangquellen austattete. Meyer-Eppler beteiligte sich anschliessend am Projekt des Funkhauses NWDR Köln, wo eine Reihe von Vorträgen und Rundfunksendungen stattfanden, die sich mit der Frage der Technologien und des elektronischen Komponierens auseindandersetzte.

Gleichzeitig untersuchte Max V. Mathews Möglichkeiten zur Übertragung von Sprachsignalen über Telephonleitungen in digitalisierter Form. Daraus entstand die Idee der Klangsynthese, die durch Computer generiert wird. 1957 entwickelte er die erste musikspezifische Computer-Programmiersprache MUSIC I und 1958 MUSIC II. Für das erste Programm wurde den PC IBM 704 verwendet. 1960 entstand in Zusammenarbeit mit Joan Miller MUSIC III. Das Programm MUSIC IV wurde dann zu einem Basismodell für eine Erweiterung der Computerfamilie. Vom gleichen Programm wurde die Version MUSIC IV B ausschliesslich für die Komponisten erarbeitet, da die vorgängigen Versionen eher für Wissenschaftler konzipiert waren. Der Nachteil dieser Versionen war, dass sie ausschliesslich auf den IBM Maschinen funktionierten. Zudem waren diese Programme mit dem Assembler Code geschrieben.

Aus diesem Grund entschied sich Arthur Roberts 1965 MUSIC IV F in FORTRAN zu schreiben, das bald von MUSIC IV FB ersetzt wurde. Zu Beginn lief das Programm viel zu langsam, so dass es an Bekanntheit verlor. Mathews arbeitete jedoch weiter und entwickelte 1968 MUSIC V, das benutzerfreundlicher war. Im gleichen Jahr entwickelte Barry Verroe MUSIC 360, das für die dritte Generation der IBM-Computer konzipiert war. Verroe vertrat die Meinung, dass die Programme auf den PC angepasst werden müssen, da hier das Betriebssystem jeweils nur nach längerem Zeitabstand verändert werde. Anfang der 1970er Jahren entwickelte er das MUSIC 11, das für die Geräte PDP 11 konzipiert war, die von der Digital Equipment Corporation konstruiert wurden. Natürlich wurden aus diesem Programm mehrere Versionen entwickelt, die dann in CSOUND mündeten.

Die letzte Version von der von Mathews entwickelten Programme, war das MUSICn, das dann endlich auch die wichtigen Computer Zentren von Australien, Candada, Frankreich, Italien, Grossbritannien, Durham und Glasgow erreichte.

Mit Karlheinz Stockhausen verbindet man den Begriff Serielle Musik, wobei diese Definition sehr problematisch ist. Das Adjektiv seriell stammt aus dem Französischen, wobei die Übersetzung nicht exakt ist.

Es handelt sich um eine neue Art des Denkens und Formens in der Komposition.

Unter Serieller Musik wird auch die Zwölftonmusik als Spezialfall erfasst. Im weiteren Sinne kann man sagen, dass die serielle Musik aus der Zwölftontechnik entstanden ist. Seit den 1950er Jahren spricht man von Serieller Musik.

Man unterscheidet zwei Formen von Serieller Musik: Punktuelle Musik, wo die einzelnen Töne einer Komposition als isolierte Phänomene betrachtet werden, und Statistische Musik, bei der Tongruppen durch Reihen fixiert werden.

Dabei handelt es sich um eine Kompositionsmethode, bei der die musikalisch bedeutenden Eigenschaften vorbestimmt oder reihenmässig organisiert werden. Tonreihen können mit kompositorischen Methoden wie Umkehrung, Transposition, Kreuz und Krebsumkehrung bearbeitet werden. Weitere Elemente können z.B. Mikrotöne, Geräusche, Glissandi, Lautstärke oder Klangfarben sein.

Diese Kompositionsmethode wurde für Stockhausen erst möglich, als ihm im Studio für elektronische Musik ein Sinustongenerator zur Verfügung gestellt wurde. Vorher konnte man mit den Parametern der Klänge nicht seriell arbeiten. Mit diesem Gerät konnte die Frequenz, Amplitude und Dauer jedes Sinustones bestimmt werden. Die Sinustöne konnten auch überlagert werden, so dass neue Klänge entstanden. Eigentlich wurden damit die ersten Versuche mit der Klangsynthese

Diese Kompositionsmethode wurde für Stockhausen erst möglich, als ihm im Studio für elektronische Musik ein Sinustongenerator zur Verfügung gestellt wurde. Vorher konnte man mit den Parametern der Klänge nicht seriell arbeiten. Mit diesem Gerät konnte die Frequenz, Amplitude und Dauer jedes Sinustones bestimmt werden. Die Sinustöne konnten auch überlagert werden, so dass neue Klänge entstanden. Eigentlich wurden damit die ersten Versuche mit der Klangsynthese  gestartet, die heute von den Computern übernommen werden, obwohl in der heutigen Zeit diese Technik immer noch nicht perfektioniert ist. Deshalb muss man sich bewusst sein, dass dies zu jener Zeit nur in eingeschränktem Rahmen möglich war, doch war diese Technik wegweisend.

gestartet, die heute von den Computern übernommen werden, obwohl in der heutigen Zeit diese Technik immer noch nicht perfektioniert ist. Deshalb muss man sich bewusst sein, dass dies zu jener Zeit nur in eingeschränktem Rahmen möglich war, doch war diese Technik wegweisend.

Parallel zu den Experimenten der elektronischen Musik entwickelte sich natürlich auch die Popularszene der Musik.

Wenden wir uns etwas der technologischen Entwicklung in der Unterhaltungsmusik zu. Hierbei werden einige Persönlichkeiten der Popszene erwähnt. Dadurch wird die historische Wichtigkeit dieser Bands in bezug auf die Entwicklung der elektronischen Musik hervorgehoben.

Elektronische Effekte sind via Radio und Fernsehen in das Leben von Millionen von Menschen seit den 1965er Jahre eingedrungen.

Anfangs der 1960er Jahre begann man Begriffe wie Live Electronics, Live Electronic Music, usw. zu verwenden. Man versteht darunter elektroakustische Musik, die mit Hilfe von einem Interpeten auf der Bühne in Echtzeit entsteht. Dieser Begriff unterscheidet sich im deutschprachigen Raum in der Bedeutung von Nordamerika. Für die Nordamerikaner handelt es sich bereits um Live Elektronische Musik, wenn ein vorproduzierter Tonträger von einem oder mehreren Musiker eingespielt wird. In Deutschland versteht man darunter entweder Klangmaterial, das in Echtzeit auf der Bühne synthetisiert wird, oder Klänge von akustischen Instrumenten oder auch die menschliche Stimme, die unmittelbar elektronisch transformiert werden.

Die Pionierarbeit der Effekte von Karlheinz Stockhausen in seinem Sudio in Köln wurden im kommerziellen Sektor angewendet. Die technologischen Erfindungen wurden im Grunde von der Populärmusik seit den 1920er Jahren benützt. Die Tanzbands benützten bereits einfache Arten der Verstärkung und die zunehmende Wichtigkeit der elektrischen Gitarre in den 1950er Jahren führte zur Weiterentwicklung der neuen Technologien.

Weitere Manipulationen wurden mit dem Wah-Wah Dämpfer und den Fuzz-Tone-Effekten möglich. Fuzz-Tone-Effekte werden durch ein Frequenzmultiplikator erzeugt, der jede Note mit komplexen Partialtönen bereichert. Auch Keyboards und elektrische Pianos profitierten von den technologischen Entwicklungen.

Schon vor den 1960er Jahren experimentierten Popgruppen mit den zur Verfügung stehenden neuen Technologien. Die Beach Boys verwendeten 1966 die Technik der „vocal tape transformation“ und die Klänge des Theremins im Song „Good Vibrations“. Die Beatles experimentierten mit „tape loops“ und „reversed playback“ in den Stücken „I’m only sleeping“ und „Tomorrow never knows“. In den darauf folgenden Aufnahmen haben sie auch das Multitrackverfahren angewendet. Dies war eine Technik, die natürlich nicht live angewendet werden konnte, obwohl die damaligen Rockbands hauptsächlich an Effekten arbeiteten, die während den Auftritten verwendet konnten.

Zu jener Zeit kannte man auch aufgenommene Teile oder „Interludes“, die in die Livepartie integriert und abgespielt wurden. Die Rolling Stones verzerrten die Klänge ihrer Instrumente im „Their Satanic Majesties Request“ im Jahr 1967. Auch Frank Zappa hat in der Produktion seiner Alben elektronische Effekte sowie Syntesizers verwendet. Auch Pink Floyd, Velvet Underground sowie Jimi Hendrix benützen die neusten Technologien.

Eine weitere Wende kam in den 1970er Jahren, als die Synthesizer billiger wurden und dem breiten Publikum zugänglich wurden. Seit dieser Zeit entwickeln sich verschiedene musikalische Stilrichtungen wie Disco, Hip-Hop, Ambient Music und Techno. Häufig ist es nicht einfach, sie untereinander zu unterscheiden.

Disco war in den Jahren 1974-1983 sehr berühmt. Die Aufnahmen in dieser Zeit wurden mit Hilfe von Synth’s gemacht, um die akustischen Instrumente zu ersetzen und eine Low-Cost-Produktion zu erreichen. Zu den berühmten Songs gehören „Never can say goodbye“ von Gloria Gaynor und „Waterloo“ von den ABBA.

Wir müssen eingestehen, dass es die Discomusic doch gesc hafft hat, mit wenig Aufwand, Erfolgsstücke wie „Stayin‘ alive“, „Y.M.C.A“ und „You make me feel“ zu produzieren.

hafft hat, mit wenig Aufwand, Erfolgsstücke wie „Stayin‘ alive“, „Y.M.C.A“ und „You make me feel“ zu produzieren.

Hip-Hop wurde von von Afrika Bambaataa und Grandmaster Flash entwickelt. Hip-Hop vereinigt Rap, eine Textrezitation auf rhyhtmischer Art mit einem perkussiven Hintergrund, der seine Ursprünge in der afrikanischen Musik hat. Anfang der 1970er Jahre verwendete der Jamaikaner Disc Jockey Kool Herc eine Technik, die den Pionieren der Musique Concrète bekannt war: Er entwickelte eine Rapvariante, indem er den rezitierten Text mit einer Background-Perkussion schmückte, die aus verschiedenen Aufnahmen entnommen und zusammengefügt wurden.

Ein Beispiel der Ambient Music ist Brian Eno. Dies ist eine Musik zum entspannen und „abschalten“, die scheinbar einfache bekannte Melodien abspielt, die aber beim genaueren Zuhören anspruchsvoller ist, als man annehmen würde. Bei dieser Musik wird abschichtlich kein starker Puls verwendet, da dies sonst die Eigenschaften der Sounds verdecken würde.

Techno kann man als Höhepunkt der Verwendung reiner elektronischer- und Computermusik nennen. Über den Ursprung des Begriffs Techno ist man sich nicht einig: Techno ist in Detroit während einer schwierigen Zeit entstanden, als die Arbeitslosenquote besonders hoch war. Die Pioniere sind Juan Atkins, Derrick May und Kevin Saunderson, die 1985 „No UFOs“ produziertren. Was Techno ausmacht, ist der Gebrauch von analoger und digitaler Technologie. Die späteren Stilrichtungen wie Minimal Techno, Trance usw., benützen Synthesizer, Sampler und Signalprozessoren. Dieser Trend ist deshalb so wichtig, weil er auch die Beziehung zwischen dem Komponisten und den technischen Möglichkeiten neu definiert. Der Komponist ist sozusagen abhängig von den neuen Technologien, die ihm zur Verfügung stehen.

Das Wort Computer stammt aus dem Lateinischen „computare“, was soviel wie zusammenrechnen bedeutet. Tatsächlich sind Computer frei programmierbare Rechenmaschinen, die nach dem Prinzip Eingabe-Verabeitung-Ausgabe funktonieren.

Das Wort Computer stammt aus dem Lateinischen „computare“, was soviel wie zusammenrechnen bedeutet. Tatsächlich sind Computer frei programmierbare Rechenmaschinen, die nach dem Prinzip Eingabe-Verabeitung-Ausgabe funktonieren.

Unter Computermusik versteht man Musik, die durch den Computer erzeugt wird. Dabei kann der PC zur Generierung von oder zur Bearbeitung von elektroakustischen Klängen (Klangsynthese) verwendet werden. Mit spezifischen Programmen kann auch komponiert werden (Partitursynthese). Programme sind nichts anderes als Algorythmen, die von einem Computer codiert werden.

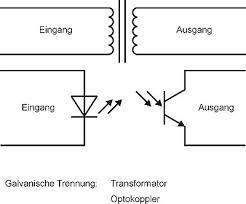

Zudem kann der Computer zu Steuerung und Beeinflussung von anderen Musikgeräten eingesetzt werden. Der PC ist eine digitale Maschine, wobei das Hören ein analoger Vorgang ist. Dabei werden die Zahlen des PC in analoge-elektrische Spannungskurven umgewandelt, die als Endresultat über die Lautsprecher zu hören sind. Dazu benutzt man eine Digital-Analog-Wandler. Umgekehrt verwendet man einen Analog-Digitalen-Wandler, wenn Schallereignisse auf dem PC übertragen werden.

Im Zusammenhang mit Computer- und digitaler Musik sind noch die Begriffe Sampler, MIDI Sequenzer und Synthesizer zu klären.

Der Sampler wie der Synthesizer sind feste Bestandteile eines elektroakustischen Studios. Ein Sampler ist ein elektronisches Instrument, bzw. ein Computer, der analoge Känge digital aufnimmt, speichert, bearbeitet sowie wiedergibt. Der Sampler ist jedoch nicht geeignet, Klänge nach oben oder unten zu transponieren, da dies den ursprünglichen Klang verfälscht, ähnlich wie die Tonbandgeräte, die bei der Transposition von einer Oktave nach oben die Dauer des Klanges um die Hälfte verkürzen.

Der Sampler hat den kommerziellen Vorteil, dass die Präsenz des Musikers für die Wiedergabe der Musik nicht nötig ist.

MIDI ist die Abkürzung für Musical Instrument Digital Interface, deutsch Schnittstelle. Sie verbindet einen Computer mit peripheren Geräten. Sie ermöglicht die Kommunikation zwischen dem Computer und den verschiedenen Effektgeräten und elektronischen Instrumenten. Auch akustische Instrumente können durch das MIDI-Interface mit dem Computer verbunden werden, z.B. um Aufnahmen zu machen. Zudem können die Daten in Echtzeit an weitere Sampler oder Syntesizer übermittelt werden, die dann gleichzeitig klingen.

Mit dem Sequenzer können keine Klänge aufgenommen werden.

Der Synthesizer ist ein kompaktes, analoges Studio mit Klaviatur, dass 1964 vom Amerikaner Robert A. Moog neu entwickelt wurde. Der Begriff Synthesizer stammt aus der Firma  RCA Electronic Music Synthesizer von 1955 hat aber mit seinem Vorgänger nichts gemein.

RCA Electronic Music Synthesizer von 1955 hat aber mit seinem Vorgänger nichts gemein.

Moogs Synthesizer unterscheidet sich von seinen Vorläufern durch die Spannungsteuerung, die es ermöglicht, die Parameter wie Frequenz, Amplitude oder Klangfarbe durch Veränderungen von den an den entsprechenden Modulen angelegten Spannungen zu beeinflussen.

Der analgoge Syntesizer arbeitet mit der subtraktiven Klangsynthese, d.h. aus einem teiltonreichen Klang werden mehrere Teiltöne filtriert und somit abgeschwächt oder ganz eliminiert.

Die ersten Syntesizer waren monophon, polyphone Modelle wurden ab 1975 produziert.

Ab 1977 wurde auch die Digitaltechnik in die Syntesizertechnik eingeführt, so dass die Analogtechnik digital simuliert oder kontrolliert wurde.

Sydney Alonso Camero Jones entwickelte in Zusammenarbeit mit John Appletin das Synclavier. Dieses Instrument ermöglichte es, die Paramenter in reeller Zeit zu übetragen, so dass man es bequem als Liveintrument benützen konnte.

Anfangs der 1980er Jahre begann man Synthesizer zu kommerziellen Produkten zu entwickeln und für die Masse zugänglich zu machen, mit dem Nachteil, dass die vorprogrammierten Klänge unveränderlich sind und die klangliche Ästhetik von der Industrie vorgegeben wird.

In der gleichen Zeit wurde sich Ikutaro Kakehashi, der Präsident der Firma Roland bewusst, dass man ein Protokoll entwickeln musste, um die verschiedenen Instrumente kompatibel zu gestalten, so dass der Informationsaustausch gewährleistet werden konnte.

Das MIDI-Protokoll stellt den Klang nicht direkt dar, sondern besteht aus Befehlen zur Ansteuerung von digitalen Instrumenten oder der Soundkarte im PC wie „Note-on“, Beginn einer Note, „Note-off“, Ende einer Note, „Key-velocity“, Anschlagstärke sowie die Tonhöhe oder das Instrument. Darauf entwickelte Dave Smith das MIDI, worauf später nochmal eingegangen wird. 1983 entickelte Yamaha den ersten digitalen Syntesizer mit integriertem MIDI, das Yamaha DX Das DX basiert auf dei FM-Synthese, ein kompliziertes Synthese-Verfahren, das von John Chowing 1967 an der Stanford Unervisity entwickelt wurde. Das DX ermöglichte ein breites Spektrum an Klängen, auch deshalb, weil der Klang durch die Spielweise beinflusst werden konnte.

Kurz danach entwickelte Dave Oppenheim von der Opcode System ein MIDI für Macintosh, der mit dem MIDI eines Syntesizers Informationen austauschen konnte.

Die heutige Technologie erlaubt es jedem Musiker oder auch Musikliebhaber mit einer relativ kleinen Investition sich mit einem Homerecording-Studio auszurüsten.

Die üblichen Aufnahme-Studios lassen sich auf drei Grundtypen zurückführen: Das Mehrspur-Studio für Audioaufnahmen, das MIDI-Studio und das Hybridstudio.

Das „klassische“ Audio-Mehrspuhrstudio dient zur Aufnahme von Audiosignalen mit Mikrofonen, Keyboard, Instrumenten, Stimme, Tonabnehmer und Verstärker.

Im MIDI-Studio werden MIDI-Daten aufgezeichnet, somit handelt es sich nicht direkt um Audiosignale, sondern um Informationen über Tonhöhe und Dynamik einer angeschlagenen Note.

Ein Hybridstudio ist heute das häufigste benutzte Studio: Dabei handelt es sich um eine Kombination aus Audio- und MIDI-Studio.

Von den Musikern werden häufig Kompaktstudios verwendet, die man bequem mitnehmen kann. Dabei unterscheidet man zwischen Analoges-, Digitales- und MIDI-Kompaktstudio.

Ein klassisches Studio besteht aus vielen Geräten: Mutlitrack-Recorder, Mischpult, Mikrofone, Signalprozessoren, darunter auch Psychoakustik- und Masteringprozessoren.

Der Multitrack-Recorder ist das Herzstück eines Tonstudios. Er erlaubt die Aufnahme auf unabhängigen Spuren. Man kann somit zeitlich nacheinander oder gleichzeitig aufnehmen.

Das Mischpult ist die logistische Zentrale der Audio-Daten. Alle Geräte, die Audiosignale erzeugen und aufzeichnen, sind hier angeschlossen und können bearbeitet werden. Zudem wird bestimmt, wo diese Informationen fliessen. Das Prinzip ist immer das gleiche: Die Signale werden an den passenden Eingängen empfangen, die Lautstärke und der Klang werden bearbeitet und zu den richtigen Ausgängen geführt.

Das Mikrofon ist der Anfang der Übertragungskette und hat die schwierige Aufgabe, die Funktion des menschlichen Ohres künstlich nachzubilden. Seine Aufgabe ist, Schallwellen in elektrische Schwingungen umzuwandeln. Das Mikofon besitzt eine Membran, die durch den Schall in Schwingungen versetzt wird. Diese werden in einem Wandler in elektrische Wechselspannung umgesetzt.

Für das Mikrofon gibt es zwei wichtige Charakteristika: Die Art der Schallwandlung und die Richtcharakteristik. Bei der Schallwandlung unterscheidet man zwischen dynamischen und Kondensatormikrofonen. Diese beide Mikrofonetypen unterscheiden sich in der Membran: Beim dynamischen Mikrofon bewegt sich ein elektrischer Leiter im engen Spalt eines starken Magneten hin und her, wodurch an seinen Enden eine elektrische Wechselspannung enststeht. Beim Kondensatormikrofon dient die Membran mit einer festen Gegenelektrode als Kondensator. Die Kapazität hängt vom Abstand der Elektroden zueinander ab.

Dynamische Mikrofone haben den Vorteil, dass sie eine gute Klangqualität haben und hohe Schalldruckpegel ertragen. Kondensatormikrofone haben eine höhere Übetragunsqualität, vertragen aber nicht so hohe Schalldrucke wie die dynamischen Mikrofone. Zur Richtcharakteristik unterscheidet man vier Hauptkategorien: Kugel-, Nieren-, Hypernieren- und Achtercharakteristik. Das Mikrofon mit Kugelcharakteristik nimmt den Schall aus allen Richtungen gleich gut auf. Die Nierencharakteristik hat den höchsten Übertragunsfaktor nach vorne. Hinten ist das Mikrofon am unempfindlichsten. Durch die Bündelung der Empfindlichkeit nach vorne ist der Pegel bei gleichem Abstand der Schallquelle dreimal so hoch wie beim Mikrofon mit Kugelcharakteristik. Zudem werden die tiefen Bässe aus allen Richtungen gleich gut übertragen.

Die Hypernierencharakteristik hat eine stärkere Bündelung nach vorne, als die Nierencharakteristik, und eine geringere bei 120°. Der von vorne kommende Schall wird in einem viermal so hohen Pegel umgewandelt gegenüber einem Mikrofon mit Kugelcharakteristik. Das Mikrofon mit Achtercharakteristik nimmt den Schall in den beiden Richtungen am besten auf, die sich senkrecht zur Membranfläche verhalten.

Die Richtcharakteristik ist somit das wichtigste Merkmal bei der Auswahl eines Mikrofons.

Signalprozessoren sind Geräte, die eingesetzt werden, um das Audiosignal zu verändern. Diese Geräte können Effekte wie Hall, Delay, Chorus, Flanger, Tremolo, Vibrato, usw. erzeugen, ähnlich wie Programme zur Bearbeitung des Direktklangs wie Kompressor, Equalizer, Enhancer einzeln oder gleichzeitig. Die meisten Effektgeräte besitzen MIDI-Anschlüsse. Der Unterschied zu den Soundprozessoren ist, dass das Signal viel unauffälliger bearbeiten als die Effektgeräte. Der wichtigste Soundprozessor ist der Dynamikprozessor, der vier wichtige Funktionen hat: Limiter, De-Esser, Expander und Noisegate. Mit dem Limiter lässt sich der maximale Pegel einstellen, der nützlich ist, um Übersteuerungen zu vermeiden. Der De-Esser ist eine spezielle Form des Kompressors. Er ist dafür zuständig, dass hohe Frequenzanteile, die in den Konsonanten s, sch, t, c, usw. enthalten sind, heruntergeregelt werden. Zudem kann er allgemein störende Zischlaute vermeiden oder abmildern.

Der Expander arbeitet umgekehrt wie ein Kompressor, d.h. er vergrössert die Dynamik. Ein anderer wichtiger Einsatz besteht in der Reduzierung von Störgeräuschen während den Signalpausen. Das Noisegate blendet Signale, die unterhalb der einstellbaren Schwelle liegen, völlig aus. Er wird angewendet, um z.B. das Rauschen oder andere Störsignale in den Signalpausen auszuschalten.

Mic-Preamps sind Mikrofon-Vorverstärker, die äusserst wichtig sind für das Gelingen eine Aufnahme: Sie sind dafür zuständig, dass möglichst alle Signale in die Signalkette aufgenommen werden. Rauschminderer werden eingesetzt, um das Rauschen, das meist in den höheren Frequenbereiche liegt, zu vermindern. Das hat den Nachteil, dass die Musik etwas dumpf klingt. Equalizer sind Schaltkreise zur gezielten Beeinflussung des Frequenzganges eines Signals.

Zu diesen Soundprozessoren gehören auch die sogenannten Psychoakustik-Prozessoren, die die Eigenschaften des menschlichen Ohres ausnützen.

Der Exciter analysiert das Klangmaterial und produziert dazu passende Obertöne, die künstlich hergestellt werden. Der Subbass-Prozessor macht sich folgenden psychoakustischen Effekt zu Nutze, um die Basswiedergabe kleiner Boxen zu verbessern: Tiefe Frequenzen besitzen gut hörbare Obertöne. Diese werden vom menschlichen Gehör analysiert und das Gehirn erzeugt den fehlenden Grundton sozusagen virtuell durch Oberton, ohne dass im Bereich des Grundtons Schall abgetastet werden kann. Ein weiterer Effekt ist der Stereo-Imager. Dieses Gerät erlaubt es, eine eng wirkende Aufnahme, in der z.B. alle Instrumente in der Mitte plaziert sind, nachträglich horizontal aufzufächern. Mit den Mastering-Prozessoren kann man den Aufnahmen die letzte Polierung geben, bevor eine CD gebrannt wird. Dabei handelt es sich um Geräte, wie z.B. Stereo-Equalizer, Multiband-Kompressor und Peak-Limiter, die im Bereich des Klangbildes Perfektionierungen möglich machen.

Hiermit wurden die wichtigsten Komponenten eines Aufnahmestudios erläutert und erklärt. Fast alle dieser obengenannten Effekte lassen sich kostengünstiger im Rechner ohne externe Hardware nachbilden. Zudem kann man die Programme mit Plug-ins erweitern.

Die Aufnahme und die Bearbeitung von Audio und MIDI im Computer hat sehr viele Vorteile. Aufwändige Hardware eines Studios, wie z.B Mixer, Multitrack-Recorder und Effektprozessoren, usw. lässt sich durch Software ersetzten. Zudem lassen sich die Programme über das Internet schnell und preiswert, wenn nicht sogar gratis, auf den neusten Stand bringen. Die Bedienung ist dank den Bildschirmansichten und der auf Windows basierten graphischen Gestaltung einfach und komfortabel. Die ganze Produktion bis zur CD-Pressung bleibt auf digitaler Ebene. Da praktisch heute alle Computer einen integrierten CD-Brenner haben, lassen sich einfach und schnell die Aufnahme vervielfältigen.

Bereits im Jahre 1965, als Sony und Phillips den Walkman lancierten, kauften sie vom nordamerikanischen Erforscher James T. Russel die Rechte für seine Erfindung, die die Benützung des Lasers für die Gravur und Wiedergabe von musikalischen Informationen vorsah.

Mit der Einführung der Compact Discs im Jahre 1981 wurde ein weiterer Schritt der Entwicklung von Tonträgern für digitale Musik erreicht.

Die Entwicklung der CD hat eine spannende Entstehungsgeschichte: In den 1970er Jahren untersuchten Sony und Phillips neue technische Möglichkeiten zur digitalen Aufzeichnung des Klanges. Sony suchte sich dazu ein prominentes Versuchskaninchen: Im September 1978 nahm sie heimlich eine Probe auf, die von Herbert von Karajan dirigiert wurde, um ihr neues Verfahren, um Störgeräusche zu beseitigen, auszuprobieren. Danach luden sie den Dirigentenen, die Aufnahme zu hören und zu kritisieren. Dies gab der Sony Anhaltspunkte, um weiter an diesem Projekt zu arbeiten. Gleichzeitig experimentierte Phillips mit neuen Möglichkeiten der Videoaufzeichnung, wobei die Speicherkapazität des Videoträgers sehr limitiert war.

Beide Firmen eigneten sich zur Festlegung eines Standards für den zukünftigen Tonträger: Er sollte mindestens die Länge der 9. Symphonie von Beethoven enthalten können. Dabei nahmen sie als Beispiel die Aufnahme von Willhelm Furtwängler, die die länge von 74 Minuten hatte. Tatsächlich entspricht der Standard einer heutigen CD rund 12 cm Durchmesser der CD entsprechen 74 Minuten Musik.

Aber wieso war die CD so revolutionär? Die CD besteht aus einem durschsichtigem Trägermaterial, dem Polycarbonat. Die Oberseite ist Träger von digitalen Informationen die in Form von mikroskopischen kleinen Vertiefungen, den Pits, und Zwischenräumen, den Lands, graviert sind. Diese zusammen bilden eine „Informationsspirale“, die eine Länge von 5 km erreicht. Diese Oberfläche wird mit einer feinen Alumiumfolie beschichtet und mit einer Lackschicht geschützt. Die Informationen werden durch DA-Wandler vom Laser eines Abspielgerätes abgetastet und wiedergeben.

Dank der Verbreitung der PCs und des Internets am Arbeitsplatz sowie im Haushalt wurde der Verbreitung der Musik eine neue Dimension gegeben: Musik ist nicht mehr an einen Tonträger (= analoge Musik) gebunden, sondern ist zu einem normalen File geworden, das mit Hilfe von Software auch zu Hause bequem bearbeitet werden kann und via Internet gesendet werden kann. Es gibt kompakte Formate der Files, wie das MP3, die das File verkleinern und dennoch die Qualität erhalten und somit die Sendung via Internet erleichtern.

Die Vorteile von den digitalen Aufnahmen liegen bei guten AD-DA-Wandlern und gegenüber Auflösung in der hohen Qualität des Tons. Zudem fehlt das Rauschen. Die Lebensdauer beträgt bei normalem Verbrauch ca. 30 Jahre und der Verschleiss ist minim. Auch bei der Kopie entsteht praktisch kein Qualitätsverlust im Gegensatz zu analogen Tonträgern.

Auf welchem Prinzip basiert die digitale Musik? Dazu machen wir einen kleinen Exkurs in die Physik. Ein klingender Ton oder allgemeiner, eine Schallquelle erzeugt Vibrationen, die sich mit dem Medium der Luft im Raum weiterverbreiten.

Unser Ohr wandelt dieses „Signal“ durch einen komplizierten Mechanismus im Innenohr in elektrische Signale, um die an unser Gehirn weitergegeben werden. Mit speziellen Maschinen ist es möglich, diese Vibrationen als Sinuswellen darzustellen. Eine Sinuswelle verrät uns viele Informationen: Die Amplitude der Welle, gibt uns den Volumen an: Je grösser die Amplitude (bei gleichbleibender Frequenz), desto lauter ist der Ton. Die Lautstärke wird in dB (Dezibel) ausgedrückt, die aus einer logarithmischen Skala gewonnen wird. Man kann sich das einfach so vorstellen: Wenn die Amplitude um 10 dB erhöht wird , hat man die zweifache Lautstärke. Unterhalb von 30-40 dB hört das menschliche Ohr praktisch nichts. Die Schmerzgrenze wird ab 120 dB erreicht.

Unser Ohr wandelt dieses „Signal“ durch einen komplizierten Mechanismus im Innenohr in elektrische Signale, um die an unser Gehirn weitergegeben werden. Mit speziellen Maschinen ist es möglich, diese Vibrationen als Sinuswellen darzustellen. Eine Sinuswelle verrät uns viele Informationen: Die Amplitude der Welle, gibt uns den Volumen an: Je grösser die Amplitude (bei gleichbleibender Frequenz), desto lauter ist der Ton. Die Lautstärke wird in dB (Dezibel) ausgedrückt, die aus einer logarithmischen Skala gewonnen wird. Man kann sich das einfach so vorstellen: Wenn die Amplitude um 10 dB erhöht wird , hat man die zweifache Lautstärke. Unterhalb von 30-40 dB hört das menschliche Ohr praktisch nichts. Die Schmerzgrenze wird ab 120 dB erreicht.

Das Timbre wird vom Spektrum ausgedrückt, die vom Material des musikalischen Instruments und von der Schallquelle abhängig ist.

Die Höhe des Tones wird von der Frequenz ausgedrückt. Die Frequenz, die in Hz (der Name des deutschen Physikers Heinrich Rudolf Hertz) angegeben wird, kann man als Anzahl der Wellen definieren, die Innerhalb einer Sekunde vibrieren.

Das menschlische Ohr hat die Fähigkeit, die Frequenzen, die sich  zwischen 20 – 20’000 Hz befinden, zu hören. Die Frequenzen im Bereich von 20 -500 Hz entsprechen musikalisch den Basstönen, die zwischen 500 – 8000 Hz der Mittellage und diejenigen zwischen 8’000 – 20’000 dem hohen Bereich.

zwischen 20 – 20’000 Hz befinden, zu hören. Die Frequenzen im Bereich von 20 -500 Hz entsprechen musikalisch den Basstönen, die zwischen 500 – 8000 Hz der Mittellage und diejenigen zwischen 8’000 – 20’000 dem hohen Bereich.

Dazu wird die Sinuswelle in kleine Abschnitte unterteilt. Die Welle wird Treppenförmig in Schritte unterteilt, die einer Pyramide gleichen. Diese Treppenabschnitte (Quanten), die jeweils ein Rechteck unterhalb der Welle formen, erhalten einen bestimmten numerischen Wert. Auf diese Weise kann man jeden kleinen Treppenabschnitt digital übersetzen, indem man die jeweiligen numerischen Werte kennt. Je kleiner die Treppenabschnitte sind, desto besser wird die Klangqualität sein, da die Form der digitalisierten Welle, sich an die reale Form der Sinuswelle anschmiegt. Je enger die Welle ist, desto grösser ist der Anzahl der „Treppenabschnitte“ pro Sekunde. Dies bedeutet, dass die Klangqualität entsprechend besser ist. Im ersten Augenblick könnte man denken, dass die analoge Aufnahme exakter als die digitale ist, da die Aufnahme der musikalischen Wellen bei der ersteren ad continuum stattfindet.

Die heutigen Geräte können die Dimensionen der „Treppen“ aber so sehr verdichten, dass die Töne sehr präzis übernommen werden. Zudem entfällt der Störfaktor der Geräusche, die in analogen Aufnahmen vorkommen. Damit die Qualität der Aufnahme für gute und sensible Hörer bis zu 20’000 Hz gewährleistet wird, muss die Musterentnahme vom doppelten der maximalen Frequenz gemacht werden, also bis zu ca. 44’100 Hz. Dies ist die Frequenz die in der Pulse Code Modulation (PCM) vorgenommen wird, d.h. die Methode mit der die CDs die auf dem Markt erscheinen kodiert werden. Bei einer Kodierung braucht man eine Speicherkapazität von ca 10.5 MB pro Minute. Dies wir ein Problem, wenn man das File z.B. via Internet senden möchte. Aus diesen Gründen, wurden Möglichkeiten entwickelt, musikalische Files zu komprimieren und im kompakten Format zu senden. Man kann die Files so komprimieren, dass man keine Informationen verliert (lossless) oder mit Verlust an Informationen (lossy). Zum ersteren gehören die Files in Wav-Format zum letzteren das MP3-Format. Mit der Methode der Lossless-Formate kann man ein File bis auf maximal 50% komprimieren.

Die Überlegung bei den Lossy-Formaten ist die folgende: Aus psychoakustischen Forschungen hat man feststellen können, dass der grösste Teil der Menschen doch nur bis zu 15’000 Hz hört. Die Hörfähigkeit nimmt vom 35. Lebensjahr ab. Das menschliche Ohr kann sehr gut hohe Frequenzen hören, wenn die tiefen Frequenzen eliminiert werden. Zudem hat man herausfinden können, dass während den ersten Millisekunden, die einem starken und plötzlichen Klang folgen, das menschliche Ohr die schwächeren Töne nicht mehr wahrnimmt. All diese Schwächen des menschlichen Ohres hat man sich zu Nutze gemacht, um die Files von unnötiger Last, wenn wir das so bezeichnen wollen, zu befreien. Dies führt dazu, dass man der File um das Zehnfache (also bis 90%) verkleinen kann und trotzdem eine hohe Qualität des Klanges gewährleistet wird. Der Nachteil ist, dass der transformierte File nicht mehr in Originalformat umgewandelt werden kann, da ein wichtiger Teil der Informationen verloren geht. (z.B. das Programm LAME)

Seit dem 20. Jahrhundert dehnt sich der Wirkungsbereich der Musik stark aus. Bis im 19. Jahrhundert wurde die Musik nur an bestimmten Orten wiedergegeben. Jede Aufführung war einmalig. Das Grammophon und das Radio machten es möglich, dass die Musik nicht mehr an einen Ort gebunden ist. Das akustische Kulturgut beginnt frei verfügbar zu werden. Zudem ermöglicht es die unbegrenzte Reproduktion von Musik. Die gedruckten Noten waren noch ein Privileg des Bürgertrums, während die Schallplatte alle Schichten erreichte.

Durch die elektronischen Medien wird in der ersten Hälfte des 20. Jahrhunderts die Verarbeitung von verschiedener Klänge möglich. Der künstlerische Umgang mit Klängen wird entwickelt. Unter Audio Art versteht man die Klangkunst, die technische Medien verwendet. Eigentlich war es der Filmton, der die ersten Klangmontagen ermöglichte und das Prinzip der Musik-Collage entwickelte.

Im letzten Viertel des 20. Jahrhundert ist eine umfassende Technisierung von Musik zu beobachten, was die Übertragung, Speicherung und Synthese betrifft. Die Experimente von Karlheinz Stockhausen wurden auf den Computer übertragen, so dass heute jede Art von Klang digitalisiert und weiterverarbeitet werden kann.

Die nahezu parallel verlaufende Entwicklung des Computers hat die digitale Klangsynthese ermöglicht, die die Computermusik auf den heutigen Stand gebacht hat, aber auch viele neue Fragen in Bezug auf die Manipulation des musikalischen Kulturguts aufgeworfen hat.

Die Ästhetik der Popmusik wurde ebenfalls von den neuen Technologien beeinflusst. Mit dem Play-Back-Verfahren ist es möglich, dass die einzelnen Instrumente nacheinander aufgenommen werden. Die Reproduktion übernimmt die wichtigste Stellung in der Musik, so dass praktisch jeder Liveauftritt wie aufgenommen klingen soll. Das Lied im Sinne einer Melodie und einer bestimmten Harmoniefolge wird immer weniger wichtig. Der Klang und die Bearbeitungstechnik werden zum wichtigsten Kriterium.

Die Erzeugung der Musik nimmt heute neue Formen der Gestaltung an. Die Art und Weise wie man die Musik aufnimmt, verändert sich und bildet eine Zäsur in der Geschichte der Rezeption. Im Weiteren haben die heutigen Technologien auch den visuellen Teil verändert und somit die Präsenz des Musikers überflüssig gemacht.

Bis in die jüngste Zeit war die ästhetische Erfahrung der Musik mit dem Interpreten verbunden. In der Tadition des Westens geht die Interpretation eines Stückes von einer niedergeschriebenen Quelle in Form der Notenschrift aus. Der Interpret übernimmt die Rolle des Vermittlers zwischen Komponist und Publikum.

Die Computermusik hat diese einzigartigen Aufführungssituation bereichert. Mit den neuen Techniken kann man Konzerte geben, wo ein Interpret überflüssig wird. Dieses Faktum ist aber auch nur eine Interpretation. Der Punkt, der am meisten von den Gegnern der Computermusik aufgenommen ist, ist dass das menschliche Element fehlt. Mit den heutigen Technologien verschwindet die Grenze zwischen Kreator, Konsument und Interpret.

Man sollte sich bewusst machen, was alles getan wurde, welch enormer Aufwand und Erfindergeist hinter dem Techno steckt.

Du BIST nur Techno, wenn du bereit wärst all diese Wege nochmal mitzugehen, um die elektronische Musik für dich zu erhalten. Techno bedeutet nämlich vor allem: Wissenschaft, Entwicklung, integratives ARBEITEN und neue Möglichkeiten schaffen.

In den letzten Jahren wurden die physiologischen Grundlagen spiritueller Erfahrungen immer besser erforscht. Längst ist inzwischen bekannt, dass Spiritualität und Religion keine Hirngespinste sind, sondern mit messbaren Prozessen im Gehirn in Zusammenhang stehen. Nun scheint der Wissenschaft in diesem Bereich eine neue bedeutende Entdeckung gelungen zu sein. Italienische Forscher untersuchten an krebskranken Studienteilnehmern eine Fähigkeit die sie als „Selbst-Transzendenz“ bezeichnen, also das Gefühl, die Grenzen des eigenen Seins ausdehnen oder überschreiten zu können.

In den letzten Jahren wurden die physiologischen Grundlagen spiritueller Erfahrungen immer besser erforscht. Längst ist inzwischen bekannt, dass Spiritualität und Religion keine Hirngespinste sind, sondern mit messbaren Prozessen im Gehirn in Zusammenhang stehen. Nun scheint der Wissenschaft in diesem Bereich eine neue bedeutende Entdeckung gelungen zu sein. Italienische Forscher untersuchten an krebskranken Studienteilnehmern eine Fähigkeit die sie als „Selbst-Transzendenz“ bezeichnen, also das Gefühl, die Grenzen des eigenen Seins ausdehnen oder überschreiten zu können.

„Der Laie meint gewöhnlich, wenn er ‚Wirklichkeit‘ sagt, spreche er von etwas Selbstverständlich-Bekanntem; während es mir gerade die wichtigste und überaus schwierige Aufgabe unserer Zeit zu sein scheint, daran zu arbeiten, eine neue Idee der Wirklichkeit auszubauen. Dies ist es auch, was ich meine, wenn ich immer betone, daß Wissenschaft und Religion etwas miteinander zu tun haben ‚müssen‘.“

– Wolfang Pauli, Pionier der Quantenphysik, Nobelpreisträger 1945

Was ist Materie ?

Bis vor einhundert Jahren haben sich die Physiker diese Frage kaum jemals ernsthaft gestellt. Ein solche einfache Frage galt schon fast als absurd, denn die Antwort war offensichtlich für jeden: Materie ist die Substanz, aus der unsere gesamte Welt besteht und die sich gemäß präzisen Gesetzen ordnet. Heute, hundert Jahre später, können die Wissenschaftler jedoch nicht mehr sagen, was Materie ist. Sie haben mittlerweile erkannt, daß die Materie eine unergründliche Energie ist, die letztlich mit den bekannten Gesetzen nicht zu fassen ist.

Bis vor einhundert Jahren haben sich die Physiker diese Frage kaum jemals ernsthaft gestellt. Ein solche einfache Frage galt schon fast als absurd, denn die Antwort war offensichtlich für jeden: Materie ist die Substanz, aus der unsere gesamte Welt besteht und die sich gemäß präzisen Gesetzen ordnet. Heute, hundert Jahre später, können die Wissenschaftler jedoch nicht mehr sagen, was Materie ist. Sie haben mittlerweile erkannt, daß die Materie eine unergründliche Energie ist, die letztlich mit den bekannten Gesetzen nicht zu fassen ist.

Woraus und „Wie“ baut sich Materie auf? Wo ist ihr Anfang? Wo ihr Ende? Wissenschaft ft. Spiritualität – Alles Karma! weiterlesen

“…Der Erleuchtung kannst du nicht entgehen- sie ist dir so gewiss wie der Sonnenaufgang.

Du kannst nicht scheitern auf dem Weg zur Erleuchtung.

Hat Dir einer etwas anderes erzählt?

Unwiderstehliche Kräfte treiben dich,

das Universum besteht darauf. Scheitern liegt nicht in deiner Macht.Es ist kein bestimmter Pfad, der zur Erleuchtung führt.

Alle Pfade führen dorthin, zu allen Zeiten.

Auf deiner Reise zur Erleuchtung erschaffst und zerstörst du deinen eigenen Pfad mit jedem Schritt.Keiner kann den Pfad des anderen gehn. Keiner kann vom eigenen Pfad abweichen. Keiner kann den anderen führen. Keiner kann umkehren, keiner kann stehenbleiben…..

Du kannst sie nicht suchen, denn sie lässt sich nicht finden.

Du kannst sie nicht finden, denn sie ging nie verloren.

Und sie geht nicht verloren, weil sie eins ist mit dem, der sie sucht….”

Jed Mc Kenna

Das Wir- oder Christus-Bewusstsein entsteht ganz allmählich, es wächst durch die Lücken des Ich-Bewusstseins und eines Tages wird es alles im Leben ausfüllen. Dann erst hat ein Mensch seine wahre Bestimmung erreicht, den Weg zur Einheit. Und wenn er diesen Weg gefunden hat, lebt er ihn in gewisser Weise für alle Menschen mit, denn wir alle sind ja, – wie wir wissen, – EINS.

Die besten Dinge im Leben kosten nichts. So ist es auch mit den Dingen, die wir geben. So oft sind es nicht die Euros, die wir bekommen, die unser Herz öffnen, Mut machen und Sorgen und miese Stimmungen wegblasen wie ein sanfter, warmer Wind aus Liebe.